はじめに

2025年に入り、生成AI技術は企業活動のあらゆる側面に深く浸透しつつあります。単なる実験的な導入フェーズを超え、多くの企業が生成AIを基幹業務や戦略的イニシアティブに組み込む段階へと移行しています。しかし、この急速な普及は同時に、情報セキュリティ、プライバシー保護、倫理的課題、そしてモデルの信頼性といった、新たな、かつ複雑な課題をもたらしています。

このような状況下で、企業が生成AIの恩恵を最大限に享受しつつ、潜在的なリスクを効果的に管理するための「AIガバナンス」の重要性が飛躍的に高まっています。『日本の人事部』が発表した「DX / 生成AI活用における課題と意向調査2025」によると、DXの目的として7割弱の企業が「守りのDX」、すなわち既存事業の効率化やコスト削減を挙げていることが明らかになりました。これは、生成AIの導入が単なる攻めの戦略だけでなく、リスク管理やコンプライアンス強化といった守りの側面においても強く求められている現状を示唆しています。

本記事では、この「守りのDX」を支え、生成AIの持続可能かつ安全な企業活用を可能にする新技術・新サービスとして、「AIガバナンスプラットフォーム」に焦点を当て、その機能、解決する課題、最新動向、そして日本企業が取るべき戦略について深掘りして議論します。

生成AIの企業活用における新たな課題

生成AIは、コンテンツ生成、顧客対応、コード開発、データ分析など、多岐にわたる業務プロセスを劇的に変革する可能性を秘めています。しかし、その強力な能力の裏側には、企業が慎重に対処すべき固有の課題が存在します。2025年現在、多くの企業がPoC(概念実証)から本格的な導入へと移行する中で、これらの課題はより顕在化しています。

- 情報漏洩リスク: 従業員が機密情報をプロンプトとして入力してしまい、学習データや外部サービスプロバイダーに意図せず共有される危険性があります。これは企業の競争力や顧客からの信頼を大きく損なう可能性があります。過去記事でも生成AIの情報漏洩リスク対策について解説しています。

- ハルシネーション(幻覚)と信頼性の欠如: 生成AIモデルが事実に基づかない情報を生成する「ハルシネーション」は、誤った意思決定や情報伝達を引き起こし、企業のレピュテーションリスクに繋がりかねません。

- 著作権・知的財産権侵害: 生成されたコンテンツが既存の著作物や知的財産権を侵害するリスクがあり、法的な問題や損害賠償に発展する可能性があります。

- 倫理的・社会的バイアス: 学習データに含まれる偏りがモデルに反映され、差別的な出力や不公平な意思決定を招く可能性があります。これは企業の社会的責任に関わる重大な問題です。

- コンプライアンスと規制対応: EU AI Actをはじめとする各国のAI規制が強化される中、企業はこれらの法規制を遵守し、説明責任を果たす必要があります。

- シャドーAIの蔓延: 従業員が企業の監視下にない生成AIツールを個人的に利用することで、セキュリティリスクやデータガバナンスの崩壊を招く「シャドーAI」の問題が深刻化しています。これに関するAI活用ルール作りも重要です。

- コスト管理とリソース最適化: 生成AIモデルの利用には高額なAPI利用料や計算リソースが必要となる場合があり、適切なコスト管理なしには運用が非効率になります。

これらの課題は、単一の技術的な解決策では対処が難しく、組織全体で統合的かつ継続的に管理するためのフレームワークが求められます。このような背景から、AIガバナンスプラットフォームの必要性が高まっているのです。

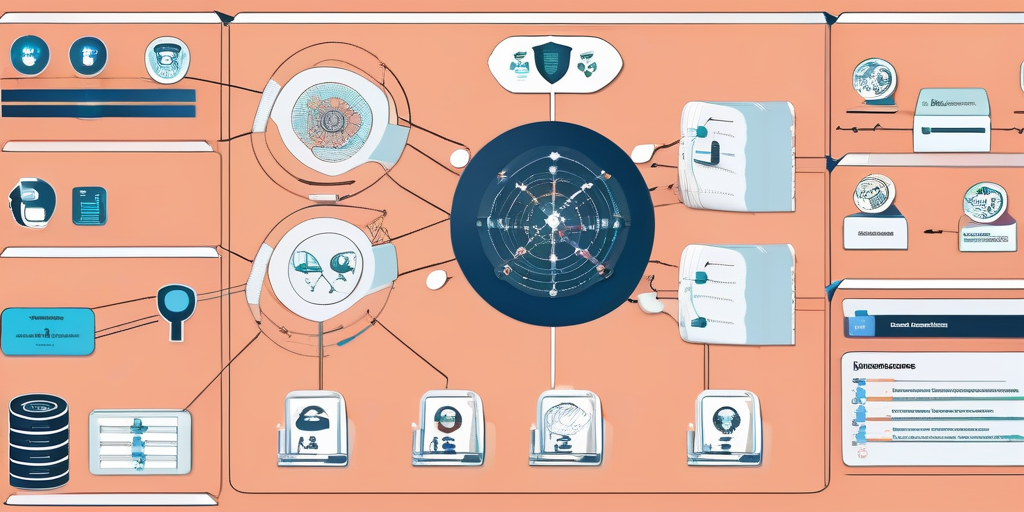

AIガバナンスプラットフォームとは何か

AIガバナンスプラットフォームとは、企業が生成AIモデルの開発、展開、運用、監視、そして廃棄に至るAIライフサイクル全体を通じて、安全性、公平性、透明性、説明可能性、セキュリティ、コンプライアンスを統合的に確保するためのシステムおよびフレームワークを指します。これは、単なるツール群ではなく、企業のAI戦略とリスク管理を一体化させるための包括的なアプローチを提供します。

AIガバナンスプラットフォームの主要な構成要素

AIガバナンスプラットフォームは、以下のような多岐にわたる機能を統合し、企業のAI活用を安全かつ効率的にサポートします。

- モデル監視とパフォーマンス管理(MLOps):

- モデルの精度とドリフト監視: モデルの出力精度が時間とともに低下していないか、現実世界の変化に合わせて性能が維持されているかを継続的に監視します。

- レイテンシとスループット管理: モデルの応答速度や処理能力を監視し、サービスレベルアグリーメント(SLA)を確実に満たすように最適化します。

- 異常検知: モデルの出力や振る舞いに異常がないかを検知し、速やかに警告を発します。

- リスク管理とセキュリティ:

- 情報漏洩対策: 機密情報がプロンプトを通じて外部に流出するのを防ぐため、プロンプトフィルタリング、データ匿名化、データマスキングなどの技術を適用します。

- プロンプトインジェクション防御: 悪意のあるプロンプトによってAIモデルが意図しない動作をするのを防ぎます。

- データプライバシー保護: 個人情報保護法(GDPR、CCPAなど)に準拠したデータ処理と保存を保証します。

- 脆弱性スキャンとセキュリティパッチ管理: 利用しているAIモデルや関連ライブラリの脆弱性を定期的にチェックし、最新のセキュリティ対策を適用します。

- コンプライアンスと倫理:

- 法規制遵守支援: 各国・地域のAI関連法規制(例: EU AI Act、日本のAI戦略)に準拠するためのガイドライン提供や自動チェック機能を提供します。

- バイアス検出と軽減: モデルの出力に含まれる潜在的なバイアス(人種、性別、年齢など)を検出し、その影響を軽減するためのツールや手法を提供します。

- 説明可能性(XAI): モデルがなぜ特定の出力を生成したのかを人間が理解できるように、その意思決定プロセスを可視化・説明する技術を統合します。

- コスト管理とリソース最適化:

- API利用料の可視化と最適化: 複数の生成AIモデルやAPIサービスを利用している場合、それぞれの利用状況とコストを統合的に管理し、コスト効率の良い選択肢を推奨します。

- リソースの自動スケーリング: 需要に応じて計算リソース(GPUなど)を自動的にスケールアップ・ダウンし、コストを最適化します。

- 予算管理とアラート: AI利用にかかる予算を設定し、超過しそうな場合にアラートを発します。

- バージョン管理と監査ログ:

- モデル・データ・プロンプトの履歴管理: どのデータで、どのモデルバージョンが、どのようなプロンプトで利用され、どのような結果を出したのかを詳細に記録し、再現性と監査可能性を確保します。

- 変更管理: モデルや設定の変更が承認されたプロセスを経て行われることを保証します。

- アクセス管理とロールベース制御:

- ユーザー認証と認可: 誰がどのAIリソース(モデル、データ、ツール)にアクセスできるかを厳密に制御します。

- ロールベースのアクセス制御(RBAC): ユーザーの役割(開発者、運用者、アナリストなど)に基づいて、必要な権限のみを付与します。

AIガバナンスプラットフォームが解決する具体的な課題

AIガバナンスプラットフォームは、前述の多岐にわたる課題に対し、以下のような具体的な解決策を提供します。

情報漏洩リスクの軽減

プラットフォームは、データ入力時の自動フィルタリング機能や機密情報マスキング技術を組み込むことで、ユーザーが意図せず機密情報をAIに渡してしまうリスクを大幅に低減します。例えば、個人を特定できる情報(PII)や企業秘密に該当するキーワードを検出し、自動的に削除または匿名化する機能です。また、外部の生成AIサービスを利用する際に、データがどのように処理され、どこに保存されるかを可視化し、企業のポリシーに合致しない場合は利用を制限するゲートウェイ機能も提供します。これにより、生成AIの情報漏洩リスク対策を強化し、企業データの安全性を確保します。

ハルシネーションと信頼性の向上

AIガバナンスプラットフォームは、RAG(Retrieval-Augmented Generation)技術の高度化を支援します。企業独自の知識ベースや信頼できる情報源と連携させることで、生成AIがより正確で事実に基づいた情報を生成するように誘導します。特に、知識グラフと連携した拡張RAGは、より精度の高い情報検索と生成を可能にし、ハルシネーションのリスクを軽減します。さらに、生成されたコンテンツのファクトチェックを自動化するツールを統合し、出力の信頼性を高めることも可能です。

コンプライアンスと倫理的利用の確保

世界中でAI規制の動きが加速する中、プラットフォームは規制要件への自動対応支援を提供します。例えば、EU AI Actのような複雑な要件に対し、モデルの透明性確保、バイアス検出、リスク評価プロセスをガイドし、必要なドキュメント生成を支援します。また、モデルのバイアスを検出するツールを組み込み、特定の属性(性別、人種など)に対する不公平な出力を特定し、是正するための推奨事項を提示することで、倫理的なAI利用を促進します。説明可能性(XAI)ツールを統合することで、AIの意思決定プロセスを可視化し、監査可能性を高めます。

コストの最適化と効率的な運用

多くの企業が複数の生成AIモデルやプロバイダーを利用する中で、コスト管理は喫緊の課題です。プラットフォームは、マルチモデル対応のAPIゲートウェイを提供し、利用状況に応じて最適なモデル(コスト、性能、セキュリティのバランス)を動的に選択することを可能にします。これにより、API利用料の無駄を削減し、リソースの効率的な配分を実現します。また、利用状況のダッシュボードを通じて、AIにかかる総コストをリアルタイムで可視化し、予算超過を防ぐためのアラート機能も提供します。

シャドーAIの防止と統制

従業員が承認されていない生成AIツールを業務に利用することを「シャドーAI」と呼びますが、これはセキュリティやガバナンス上の大きな脅威となります。AIガバナンスプラットフォームは、企業が承認したAI環境を一元的に提供し、従業員が安全かつコンプライアンスに準拠した形で生成AIを利用できるようにします。これには、企業独自のデータでファインチューニングされたモデルへのアクセス、セキュリティポリシーが適用されたプロンプト入力環境、利用状況の監視などが含まれます。これにより、AI活用ルール作りを実効性のあるものにし、組織全体のAI利用を統制します。

AIガバナンスプラットフォームの最新動向と将来展望

AIガバナンスプラットフォームは、生成AI技術の進化と規制環境の変化に合わせて、常にその機能を拡張し続けています。2025年以降、以下のトレンドが顕著になると予測されます。

マルチモーダルAIへの対応強化

テキストだけでなく、画像、動画、音声といったマルチモーダル生成AIの活用が拡大するにつれて、これらの多様なデータ形式に対するガバナンス機能が不可欠になります。プラットフォームは、画像生成における著作権問題の検出、動画コンテンツの倫理的利用監視、音声データのプライバシー保護など、各モダリティ特有のリスクに対応するための機能を統合していくでしょう。

AIエージェントの統制と管理

自律的にタスクを実行するAIエージェントの台頭は、ガバナンスに新たな複雑性をもたらします。エージェントが複数のツールやAPIを連携させて動作する際、その行動の透明性、説明可能性、そして予期せぬ結果を防ぐための制御が求められます。AIガバナンスプラットフォームは、エージェントの意思決定プロセスを記録・監査し、特定の行動パターンを制限するポリシーを適用する機能など、より高度な統制メカニズムを開発していくでしょう。これについては、AIエージェント台頭と国際競争激化やAIエージェントが拓くビジネス変革の過去記事でもその重要性を指摘しています。

規制動向との連携と自動遵守

EU AI Actをはじめとする各国のAI規制は今後も進化し、より具体的かつ厳格な要件が課される可能性があります。AIガバナンスプラットフォームは、これらの規制動向をリアルタイムで追跡し、企業のAIシステムが自動的に遵守できるように設定やポリシーを更新する機能を強化するでしょう。これにより、企業は常に最新の法規制に対応し、コンプライアンス違反のリスクを最小限に抑えることができます。

オープンソースと商用サービスの融合

柔軟性とカスタマイズ性を求める企業と、安定したサポートと包括的な機能を求める企業の両方に対応するため、オープンソースのガバナンスフレームワークと商用サービスが融合する動きが加速すると考えられます。企業は自社のニーズに合わせて、オープンソースのコンポーネントをベースにカスタマイズしつつ、特定の高度な機能やサポートを商用サービスから得るハイブリッドなアプローチを採用できるようになるでしょう。

日本企業が取るべき戦略

『日本の人事部』の調査が示すように、「守りのDX」を重視する傾向にある日本企業にとって、AIガバナンスプラットフォームの導入は、生成AIを安全かつ持続的に活用するための必須インフラとなります。2025年以降、競争優位性を確立するためには、単に生成AIを導入するだけでなく、そのガバナンス体制をいかに強固にするかが鍵となります。

日本企業が取るべき戦略としては、以下の点が挙げられます。

- スモールスタートと段階的拡大: 最初から完璧なプラットフォームを構築しようとするのではなく、まずは情報漏洩リスク対策や基本的な利用ログの取得など、喫緊の課題からスモールスタートで導入を進めるべきです。その後、利用状況や組織の成熟度に合わせて、段階的に機能を拡張していくアプローチが現実的です。

- 組織横断的な体制構築: AIガバナンスは、IT部門だけでなく、法務、リスク管理、事業部門など、組織全体が連携して取り組むべき課題です。専任のAIガバナンスチームを設置し、明確なポリシーとガイドラインを策定することが重要です。

- 自社データ活用と独自モデルの検討: 汎用モデルの利用に加えて、企業の機密データや特定の業務知識を学習させた企業独自生成AIモデルの構築も検討すべきです。これにより、データ主権を確保しつつ、よりセキュアで高性能なAI活用が可能になります。

- 従業員への教育とリテラシー向上: AIガバナンスプラットフォームを導入しても、最終的にAIを利用するのは従業員です。適切なプロンプトエンジニアリング、リスク認識、利用ルールの理解を深めるための継続的な教育が不可欠です。

- 国内外の規制動向への注視: 日本政府のAI戦略や国際的なAI規制の動向を常に注視し、自社のAIガバナンス体制がこれらの要件に適合しているかを定期的に見直す必要があります。

まとめ

2025年、生成AIは企業にとって不可欠なツールとなりつつありますが、その潜在能力を最大限に引き出しつつ、リスクを適切に管理するためには、強固なAIガバナンスが不可欠です。本記事で深掘りしたAIガバナンスプラットフォームは、情報漏洩、ハルシネーション、コンプライアンス違反、コスト増大といった多岐にわたる課題に対し、統合的かつ包括的な解決策を提供します。

『日本の人事部』の調査が示す「守りのDX」の重視は、生成AIの安全な活用がいかに企業の喫緊の課題であるかを物語っています。AIガバナンスプラットフォームは、単なるリスク回避のツールではなく、企業が生成AIを信頼性高く、効率的に、そして倫理的に利用するための基盤を築き、結果として持続的なイノベーションと競争優位性を実現するための戦略的な投資となるでしょう。

日本企業は、この新しい技術トレンドを単なるリスクと捉えるだけでなく、ガバナンスを確立することで、生成AIの真の価値を引き出す機会として捉え、積極的に導入と活用を進めるべきです。これにより、2025年以降のデジタル変革を成功に導くための強固な足場を築くことができるでしょう。

コメント